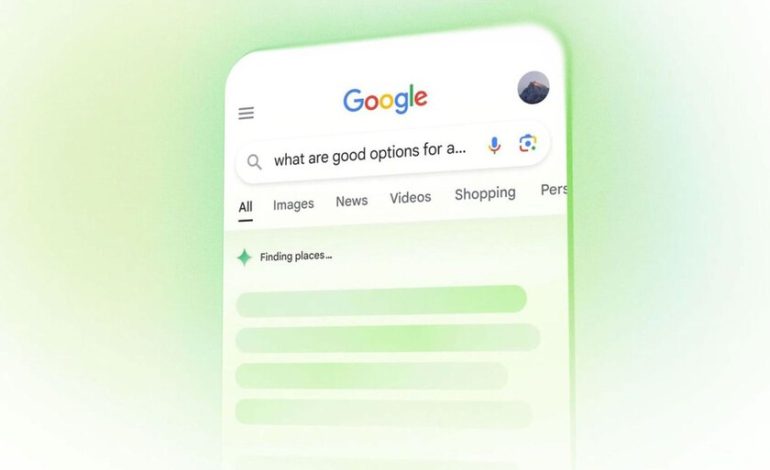

El motor de búsqueda de Google no es solo un motor de búsqueda. Dado que Google comenzó a integrar la función «Descripción general de la IA», también es un chatbot con inteligencia artificial que responde a las preguntas de los usuarios sin tener que hacer clic en ningún enlace. El problema es que la tecnología subyacente, los excelentes modelos de idiomas, funcionan de manera probable, por lo que tienden a inventar la respuesta cuando no tienen claro cómo responder.

Una mentira creíble. Esta vez, una respuesta inventada de las descripciones de IA puede terminar sentado en Google en el banco. El demandante es Wolf River Electric, una compañía de energía solar de Minnesota. Y el origen de la demanda es que la redundancia vale una demanda que nunca existió.

Según los abogados de la compañía energética, la búsqueda de los términos «demandas contra Wolf River Electric» en Google lo hizo Ai respondió con difamaciones. Citan un caso en el que las vistas generales de la IA respondieron que Wolf River Electric había sido demandado por el abogado de Minnesota por «prácticas de ventas engañosas», como mentir a los clientes sobre cuánto ahorrarán y engañarán a los propietarios para firmar contratos con tarifas ocultas.

La IA presentó el caso con la confianza total que involucró a cuatro de los gerentes de la compañía por su nombre: Justin Nielsen, Vladimir Marchenko, Luka Bozek y Jonathan Latcham, que vienen a mostrar una foto de Nielsen junto a las falsas acusaciones. Para apoyar sus declaraciones, la IA citó cuatro enlaces: tres artículos de noticias y una declaración del Fiscal General. Sin embargo, ninguno de los enlaces mencionó una demanda contra Wolf River Electric.

No es la primera vez. Este tipo de error se conoce como «alucinación», y es muy común en los modelos de lenguaje para cómo su respuesta se está tejiendo predeciendo las siguientes palabras, a veces arrastrando el error inicial hasta que se convierte en una mentira creíble con todo tipo de ramificaciones inventadas, como en el juego del teléfono en escabeche.

Cuando Google comenzó a integrar la descripción general de la IA en el motor de búsqueda, tuvo que eliminarlo de algunas búsquedas, especialmente recetas y nutrición, porque recomendó agregar pegamento a la pizza o comer una piedra al día para mantenerse saludable.

Una respuesta por pregunta. Wolf River Electric afirma que, debido a lo que leen en las descripciones de la IA, varios clientes cancelaron sus contratos, valorados en hasta $ 150,000. El problema es que las respuestas de las descripciones de la IA son personalizadas: se infieren en ese momento, por lo que puede variar de una consulta a otra

Eso para los abogados de Wolf River Electric no está preocupado porque saben que puede volver a suceder. «Esta demanda no se trata solo de defender la reputación de nuestra empresa; defenderá la equidad, la verdad y la responsabilidad en la era de la inteligencia artificial». Nicholas Kasprowicz diceAsesor legal de la empresa.

David contra Goliat. El caso se presentó en marzo en un tribunal estatal y acaba de ser elevado a un tribunal federal de los Estados Unidos. Quizás termine creando jurisprudencia sobre si una empresa de tecnología debe asumir la responsabilidad de su generación y desinformación. La respuesta a esta pregunta podría marcar un punto de inflexión para las empresas de IA, que durante mucho tiempo han tratado de evitar la responsabilidad de los resultados de sus modelos de idiomas.

Google, en su defensa, describió el incidente como un accidente inofensivo. «La gran mayoría de nuestras descripciones de IA son precisas y útiles, pero como con cualquier tecnología nueva, pueden ocurrir errores». Un portavoz de la compañía dice. Google dice que rápidamente ha actuado para resolver el problema tan pronto como tenían conocimiento de él, en línea con sus recientes esfuerzos para permitir a los usuarios corregir los errores de IA.

Imagen | Google

En | La IA de Google aconseja usar pegamento de queso de pizza. La fuente es un comentario de Reddit hace 11 años

(Function () {window._js_modules = window._js_modules || {}; var headelement = document.getelegsbytagname (‘head’)[0]; if (_js_modules.instagram) {var instagramscript = document.creatElement (‘script’); instagramscript.src = «instagramscript.async = true; instagramscript.defer = true; headelement.appendChild (Instagramscript);}}) (); –

La noticia

Una compañía de energía solar ha demandado a Google por la IA de su motor de búsqueda: se inventó que eran estafadores

Fue publicado originalmente en

Por Matías S. Zavia.