«Con la inteligencia artificial en consulta podemos volver a mirar a los ojos al paciente». Esto es lo que opina Manel Ramos, médico internista del Hospital Clínic de Barcelona y Director del Máster IA en Investigación y Docencia de la Universitat de Barcelona.

La idea puede parecer paradójica: automatizar procesos para centrar la atención en lo humano, pero esta tecnología vendría a corregir un problema generado por una anterior. Con los registros digitales en consulta, positivos en muchos aspectos, «pasamos de ser escuchantes a escribientes, el médico profesional solo mira la pantalla porque está rellenando campos predefinidos», explica Ramos. Así que si la IA se encarga de la parte burocrática, los médicos pueden concentrarse en atender a los pacientes.

Ramos se refiere a unos programas conocidos como escribas médicos (Medical Scribe), que se están probando como programa piloto en el Clínic y también en otros centros públicos españoles, como el Hospital La Paz, en Madrid, y centros privados como los del grupo Quirón. El objetivo es que el médico deje de ser un mero introductor de datos: que la IA capture la información mientras el profesional habla, mira y atiende al paciente, sin interrumpirse cada pocos segundos para escribir.

«El programa está en la consulta con el paciente y sirve al profesional de asistente: graba las notas de la conversación y luego hace un pequeño resumen que el profesional valida», explica Araceli Camacho, directora de Transformación Digital en el Hospital Clínic y coordinadora del piloto. El propósito, dice, es que «el profesional tenga más tiempo de calidad con el paciente». Y Ramos insiste: «Siempre hay revisión humana, es necesaria la validación de un médico».

Un largo historial de IA aplicada

Los Scribe pertenecen al ámbito de la inteligencia artificial generativa, diseñada para comunicarse en lenguaje natural y cuyo exponente más popular es ChatGPT. Desde su explosión en 2022, esta tecnología se ha integrado en múltiples tareas cotidianas. Los centros médicos no han sido una excepción.

Además de para tomar notas en consulta, Ramos señala que la IA generativa puede ayudar también con tareas administrativas: «Por ejemplo, un paciente trae 50 folios de estudios, la IA puede resumirlos en 5 minutos. El objetivo es reducir la carga burocrática y dejar que los profesionales se concentren en la atención al paciente».

Pero aunque su expansión masiva es reciente, la IA generativa aplicada a las consultas médicas no es nueva. Según Camacho, «se puede aplicar en muchos campos dentro de un hospital. Nos sirve para mejorar la calidad asistencial, buscar eficiencia en los procesos y ayudar en la investigación».

Se empieza a trabajar con IA en los años 50 y se aplica a la medicina desde los 70, con los primeros modelos de diagnóstico temprano de enfermedades infecciosas. En el siglo XXI, el aumento de capacidad de procesamiento ha permitido entrenar algoritmos para prevención, diagnóstico, tratamientos personalizados y gestión hospitalaria.

En el Hospital Universitario La Paz, por ejemplo, la IA se utiliza «en 24 servicios clínicos a través de unos 40 proyectos que cubren prácticamente todo el espectro de la IA: desde robótica hasta IA generativa y predictiva, basada en textos, datos estructurados, señales o imagen médica», cuenta Fernando Martín Sánchez, Subdirector Gerente para Informática Médica, Estrategia Digital e Innovación en el centro madrileño.

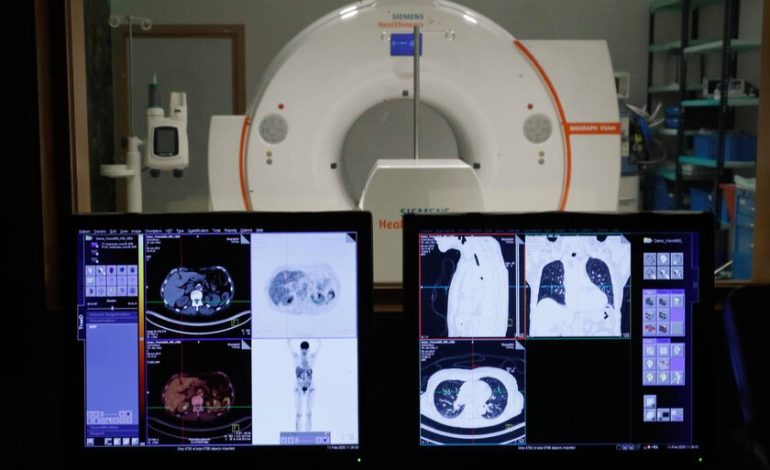

Se benefician prácticamente todas las disciplinas, desde cardiología a neurología, pasando por anatomía patológica. Pero dónde la IA avanza a más velocidad es en el campo de la imagen: radiología, TAC, resonancias, endoscopias. «La radiología es donde más rápido se está integrando la IA», señala Ramos. «Ayuda a confirmar resultados normales, prioriza casos urgentes y reduce la carga de los radiólogos».

También son destacables los avances en dermatología (donde es capaz de hacer un cribado de imágenes de lesiones) o en oncología: (con un gran desarrollo de la selección de tratamientos personalizados). Sin embargo, «lo más cercano al contacto humano directo, como psicología o psiquiatría, avanza más lento, por suerte», añade Ramos.

Empresas españolas como Quibim han publicado estudios que muestran incrementos significativos en sensibilidad diagnóstica en tumores específicos. También existen sistemas en oftalmología para detectar retinopatías o glaucoma.

En estos casos, se trata de inteligencia artificial predictiva o discriminativa, basada en redes neuronales y aprendizaje profundo (deep learning). «Este tipo de sistemas se entrenan con una gran cantidad de datos. Por ejemplo, se le proporciona gran cantidad de imágenes de pacientes con neumonía y otras de pacientes sanos. El modelo aprende a reconocer patrones y, cuando se le presenta una imagen nueva, puede determinar si se trata o no de una neumonía», explica Martín Sánchez.

Por otro lado, la robótica para intervenciones quirúrgicas es una herramienta felizmente implantada en alrededor de 80 hospitales españoles, donde el robot cirujano Da Vinci ha realizado miles de operaciones en oncología, o incluso para trasplantes de órganos, durante los últimos años.

Pero una implantación lenta en España

El ritmo de implantación de estas herramientas sigue siendo «muy bajo», a ojos de Manel Ramos. «Cada área incorpora estas tecnologías a un ritmo distinto: lo más cercano a la imagen va más rápido, lo más cercano al trato personal va más lento».

El quid de la cuestión de esta lentitud es que todo debe ajustarse a rígidos protocolos, algunos aún en elaboración. Hay, por ejemplo, «que vigilar la protección de datos del paciente. Los registros de voz son delicados, el paciente debe dar su consentimiento informado y saber que se está grabando», advierte Ramos.

Además de la Ley de Protección de Datos, en España, a nivel europeo se aprobó en junio de 2024 otra norma crucial para la entrada de tecnologías de este tipo en distintos ámbitos, también en medicina, la Ley Europea de Inteligencia Artificial, que introduce un marco legal común para evaluar el nivel de riesgo de los sistemas antes de su uso. Los de alto riesgo (como los sanitarios) deberán cumplir con requisitos de transparencia, supervisión humana y calidad de datos.

La norma también prohíbe prácticas inaceptables como la manipulación cognitiva o la identificación biométrica en tiempo real en espacios públicos, e impone transparencia a las herramientas generativas, que deberán informar cuando el contenido haya sido creado artificialmente.

Por su parte, el Ministerio de Sanidad espera aprobar «próximamente» la Estrategia de Inteligencia Artificial (IA) en el Sistema Nacional de Salud (SNS). Y a nivel autonómico, las comunidades también invierten en planes que incorporan IA para agilizar cribados y reducir tiempos de diagnóstico de enfermedades como el cáncer.

«Todo esto son iniciativas que surgen de abajo arriba; es decir, son los propios servicios los que detectan una necesidad y, bien con sus propios medios o bien a través de colaboraciones, han desarrollado estos pilotos y los están probando», cuenta Martín Sánchez. Es decir, la implantación de la IA en Sanidad no parte de una estrategia coordinada a nivel nacional o regional ni hay listas oficiales. Sin embargo, los hospitales «tenemos que adecuarnos a la legislación vigente, como el Reglamento de IA de la Unión Europea o la Ley de Protección de Datos».

Y cuando por fin entra la IA en un hospital, no se acaba el proceso: hay que evaluar si esta tecnología de verdad cumple con las ventajas que promete, o se trata de una pérdida de tiempo y dinero, así como un perjuicio para el paciente. «Desarrollar un sistema puede llevar un año, pero evaluarlo clínicamente, tres o cuatro. Además no está claro quién debe hacerlo: el hospital, el proveedor o la administración; la ley europea no entra en la efectividad clínica, solo exige demostrar precisión y fiabilidad», explica Martín Sánchez.

Para Ramos, la clave está en la metodología científica: “Esto no deja de ser un estudio científico, con hipótesis, objetivos, metodología y protección de datos. Todo debe pasar por un comité de ética para verificar que se cumplen las leyes y que el paciente está cubierto. Eso enlentece mucho la implantación”.

¿Es realmente fiable la IA a nivel médico?

Sánchez apunta que «las IAs predictivas son las más fáciles de evaluar que las generativas. Puedes probarlas con un conjunto de imágenes nuevas y medir cuántas veces aciertan. Si aciertan en el 99%, puedes confiar razonablemente en ellas. Esto no ocurre con la generativa, que produce contenido nuevo. Su evaluación es mucho más compleja».

«Una cosa es probar que la tecnología funciona y otra demostrar que mejora los resultados de salud. Todavía no hay una metodología universal para evaluar esa efectividad clínica. Ni médicos ni pacientes se van a fiar de un sistema que no demuestre beneficios reales», añade.

La IA sigue enfrentando riesgos. «La inteligencia generativa sabemos que tiene esas alucinaciones, o sea, que se puede inventar cosas», advierte Martín Sánchez, haciendo referencia a las respuestas falsas o inventadas por modelos como ChatGPT, por datos insuficientes o sesgos en el entrenamiento.

Ramos cree que esos riesgos se están reduciendo con modelos más potentes: «Los errores suelen deberse a no hacer la pregunta adecuada o a no validar la respuesta. A veces, se pide a la máquina un 0% de error cuando los humanos tampoco lo tenemos». Y añade: «Yo, como internista, que me dedico a enfermedades autoinmunes, y puedo pedir una opinión sobre el lupus o el Crohn porque luego validaré la respuesta, pero no puedo pedirla sobre un caso complejo de cáncer porque no voy a saber si se equivoca».

Además, los algoritmos que gobiernan estas IAs reflejan por lo general sesgos humanos, lo que puede ser peligroso cuando toman decisiones. En junio, el medio Civio reveló que Quantus Skin, un sistema de detección de cáncer de piel que iba a ser implantado en el País Vasco, pasaba por alto uno de cada tres melanomas, con una sensibilidad del 69%, y obviaba a los pacientes de piel oscura porque había sido entrenado solo con pacientes blancos. Los especialistas calificaron sus resultados de «pobres» y «peligrosos».

Otra investigación del mismo medio alerta de una anomalía que ya se está produciendo en hospitales españoles: la IA, según cuentan, se está integrando en la sanidad pública española a través de sistemas como Eyelib, un robot que realiza diagnósticos oftalmológicos, y que se presenta como una solución a las listas de espera, pero que se usa sin informar previamente a los pacientes de sus datos van a ser usados en un sistema de inteligencia artificial.

Hacia el fin de los «rellenadores»

Para que la Sanidad pueda trabajar valiéndose de la IA sin que sea un lastre, la formación del personal es esencial. «Tenemos retos de integración y de adaptación de los equipos. Hay que formar al personal. La inteligencia artificial supone un cambio no solo en sanidad, sino en todos los ámbitos», señala Araceli Camacho. El experto de La Paz coincide: «Estamos haciendo un gran esfuerzo por formar a clínicos e investigadores. Tenemos varios cursos al año, pero también necesitamos expertos permanentes en inteligencia artificial en salud. Y eso cuesta mucho conseguirlo».

Además, las consecuencias para el medioambiente del uso desmedido de la IA preocupa a los expertos. En la Universidad Complutense de Madrid advierten del impacto ambiental: los centros de datos necesarios para entrenar y ejecutar modelos de IA consumen grandes cantidades de agua y energía. Se estima que por cada veinte respuestas generadas por herramientas como ChatGPT se utiliza un litro de agua. Para mitigar estos efectos, proponen mejorar la eficiencia hídrica, ubicar los centros en zonas adecuadas y promover un etiquetado ambiental.

Según Martín Sánchez «entrenar modelos requiere electricidad, agua para refrigerar los centros de datos y produce residuos. En el hospital tenemos una unidad dedicada a estudiar estos temas y sensibilizar al personal para que no se haga un uso desmesurado. Es como dejarse la luz encendida toda la noche: hay que usar la tecnología de forma racional».

«Esta mecánica de ser solo rellenadores de datos tiene que cambiar. Seguramente el año que viene, en 2026, ya empecemos a ver el cambio en bastantes hospitales», dice Ramos, para quien es crucial que se respete el «concepto de human in the loop, que significa que el ser humano debe estar siempre en medio de los procesos generativos, tanto al inicio como al final, con la validación».

«El impacto de esta tecnología es incluso mayor que el que tuvo la electricidad o Internet. Su influencia será absoluta, transversal en todas las áreas del conocimiento y en el día a día de las personas», concluye el internista.

En | No sabíamos por qué algunas superbacterias eran resistentes a los antibióticos. Esta IA lo ha averigado en dos días

En | La empresa china Alibaba tiene una IA para detectar el cáncer de páncreas. Es tan buena que EEUU ha acelerado su aprobación

Imagen | Comunidad de Madrid